spark 1. Spark的四大特性 速度快 spark比mapReduce快的两个原因 基于内存 1. mapreduce任务后期在计算的是时候,每一个job的输出结果都会落地到磁盘,后续有其他的job要依赖于前

spark比mapReduce快的两个原因

1. mapreduce任务后期在计算的是时候,每一个job的输出结果都会落地到磁盘,后续有其他的job要依赖于前面job的输出结果,这个时候就需要进行大量的磁盘io操作,性能较低

2. spark任务后期在进行计算的时候,job的结果是可以保存在内存中的,后面有其他的job需要以言语前面job的输出结果,这个时候可以直接从内存中读取,避免了磁盘io操作,性能比较高

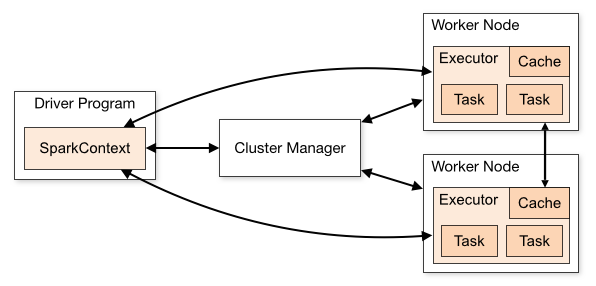

spark程序和mapreduce程序都会产生shuffle阶段,在shuffle阶段中他们产生的数据都会保留在磁盘中 1 mapreduce任务以进程的方式运行在yarn集群中,比如说有100个mapTask,一个task就需要一个进程,这些task要运行就需要开启100个进程

2 spark任务以线程的方式运行在进程中,比如说有100个task,则一个task就对应一个线程

A list of dependencies on other RDDs

一个RDD会依赖于其他多个RDD

这里是说RDD和RDD之间是有依赖关系的,spark任务的容错机制就是根据这个特性(血统)而来Optionally, a Partitioner for key-value RDDs (e.g. to say that the RDD is hash-partitioned)

一个Patitioner,即RDD的分区函数(可选项)

spark中实现了两种类型的分区函数

1 基于哈希的HashPartitioner,(key.hashcode % 分区数 = 分区号)

2 基于范围的RangePartitioner

只有对于key-value的RDD,并且产生shuffle,才会有Partitioner

非key-value的RDD的Partitioner的值是NoneOptionally, a list of preferred locations to compute each split in (e.g. block locations for an hdfs file)

一个列表,存储每个Partition的优先位置(可选项)

spark任务在调度的时候会优先考虑存有数据的节点开启计算任务,以减少数据的网络传输,提成计算效率| 转换 | 含义 |

|---|---|

| map(func) | 返回一个新的RDD,该RDD由每一个输入元素经过func函数转换后组成 |

| filter(func) | 返回一个新的RDD,该函数由经过func函数计算并且返回值为true的输入元素组成 |

| flatMap(func) | 类似于map,但每一个输入元素可以被映射为0或多个输出元素(所以func应该返回一个序列,而不是单一的元素) |

| mapPartitions(func) | 类似于map,但独立地在RDD的每一个分片上运行,因此在类型为T的RDD上运行时,func的函数类型必须是Iterator[T] => Iterator[U] |

| mapPartitionsWithIndex(func) | 类似于mapPartitions,但func带有一个整数参数表示分片的索引值,因此在类型为T的RDD上运行时,func的函数类型必须是Iterator[T] => Iterator[U] |

| union(otherDataset) | 对源RDD和参数RDD求并集,并返回一个新的RDD |

| intersection(otherDataset) | 对源RDD和参数RDD求交集,并返回一个新的RDD |

| distinct([numTasks])) | 对源RDD进行去重之后返回一个新的RDD |

| groupByKey([numTasks]) | 在一个(k,v)类型的RDD上调用,返回一个(k,v)的RDD |

| reduceByKey(func, [numTasks]) | 在一个(k,v)类型的RDD上调用,返回一个(k,v)的RDD,使用指定的reduce函数,将相同key的值聚合到一起,与groupByKey类似,reduce任务的个数可以通过第二个参数来设置 |

| sortByKey([ascending], [numTasks]) | 在一个(k,v)的RDD上调用,k必须实现Ordered接口,返回一个按照key进行排序的(k,v)RDD |

| sortBy(func,[ascending], [numTasks]) | 与sortByKey类似,但是更灵活,可以自定义排序func |

| join(otherDataset, [numTasks]) | 在类型为(k,v)和(k,w)的RDD上调用,返回一个相同 key对应的所有元素对在一起的(k,(v,w))的RDD |

| cogroup(otherDataset, [numTasks]) | 在类型为(K,V)和(K,W)的RDD上调用,返回一个(K,(Iterable |

| coalesce(numPartitions) | 减少RDD的分区数到指定值 |

| repartition(numPartitions) | 重新给RDD分区 |

| repartitionAndSortWithinPartitions(partitioner) | 重新给RDD分区,并且每个分区内以记录的key排序 |

| 动作 | 含义 |

|---|---|

| reduce(func) | reduce将RDD中元素前两个传给输入函数,产生一个新的return值,新产生的return值与RDD中下一个元素(第三个元素)组成两个元素,再被传给输入函数,直到最后只有一个值为止。 |

| collect() | 在驱动程序中,以数组的形式返回数据集的所有元素 |

| count() | 返回RDD的元素个数 |

| first() | 返回RDD的第一个元素(类似于take(1)) |

| take(n) | 返回一个由数据集的前n个元素组成的数组 |

| takeOrdered(n, [ordering]) | 返回自然顺序或者自定义顺序的前 n 个元素 |

| saveAsTextFile(path) | 将数据集中的元素以textFile的形式保存到HDFS文件系统或者其他支持的文件系统,对于每个元素,Spark将会调用toString方法,将它装换为文件中的文本 |

| saveAsSequenceFile(path) | 将数据集中的元素以hadoop sequenceFile的格式保存到指定的目录,可以是HDFS或者其他Hadoop支持的文件系统 |

| saveAsObjectFile(path) | 将数据集的元素以Java序列化的方式保存到指定的目录下 |

| countByKey() | 针对(k,v)类型的RDD,返回一个(k,int)的map,表示每一个key对应的元素个数 |

| foreach(func) | 在数据集上每个元素上,运行函数func |

| foreachPartition(func) | 在数据集的每个分区上,运行函数func |

--结束END--

本文标题: Spark基础和RDD

本文链接: https://lsjlt.com/news/3916.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-10-23

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0