Python 官方文档:入门教程 => 点击学习

本文主要给大家讲解一下,如何在yolov5中添加注意力机制, 这里提供SE通道注意力的改进方法,其他注意力的添加方法,大同小异 首先找到SE注意力机制的PyTorch代码 class

本文主要给大家讲解一下,如何在yolov5中添加注意力机制,

这里提供SE通道注意力的改进方法,其他注意力的添加方法,大同小异

首先找到SE注意力机制的PyTorch代码

class SELayer(nn.Module):

def __init__(self, c1, r=16):

super(SELayer, self).__init__()

self.avgpool = nn.AdaptiveAvgPool2d(1)

self.l1 = nn.Linear(c1, c1 // r, bias=False)

self.relu = nn.ReLU(inplace=True)

self.l2 = nn.Linear(c1 // r, c1, bias=False)

self.sig = nn.Sigmoid()

def forward(self, x):

b, c, _, _ = x.size()

y = self.avgpool(x).view(b, c)

y = self.l1(y)

y = self.relu(y)

y = self.l2(y)

y = self.sig(y)

y = y.view(b, c, 1, 1)

return x * y.expand_as(x)直接把SE注意力机制的程序,复制到models文件夹下面的common.py文件中

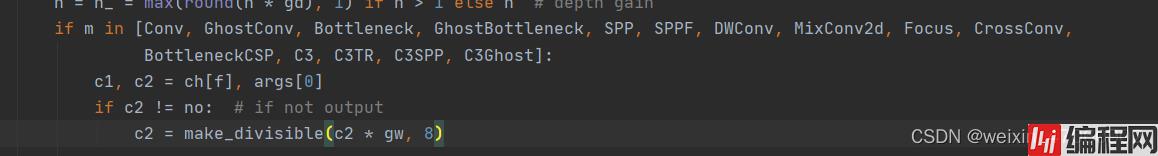

然后找到yolo.py,在这个文件中找到下面这一行

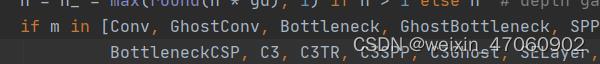

然后把SE添加到这个注册表里,

直接在C3Ghost后面加上SELayer

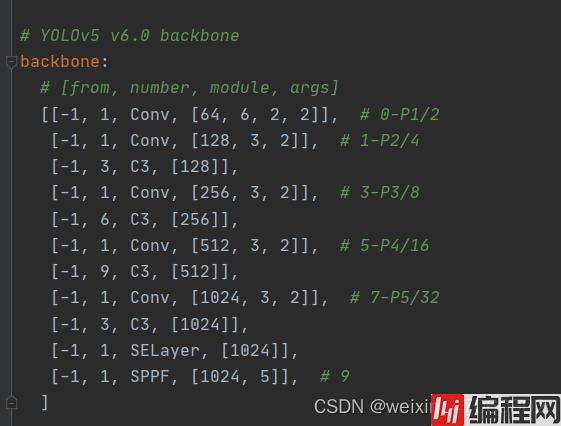

然后是要修改yaml文件,对于SE这种即插即用的注意力机制,输入和输出的通道数相同,所以不会影响其他模块的运行

注意力机制也可以插在其他地方,只要注意把通道数对应好就行

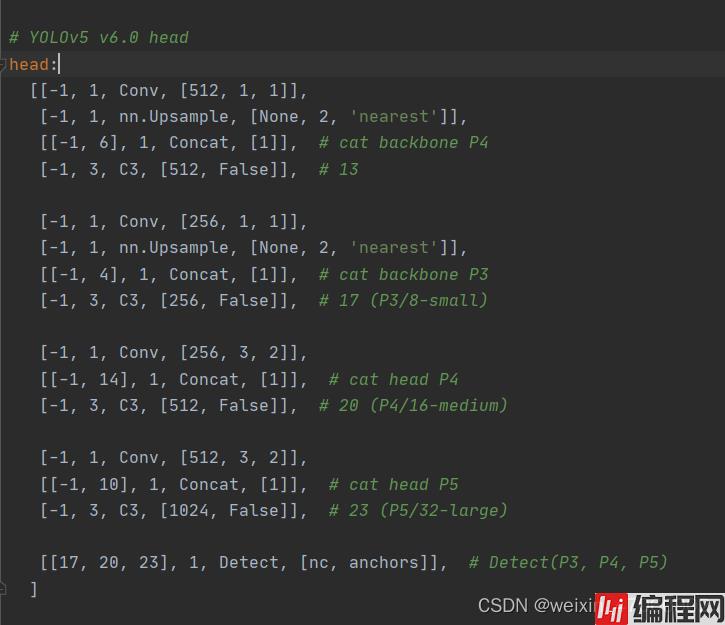

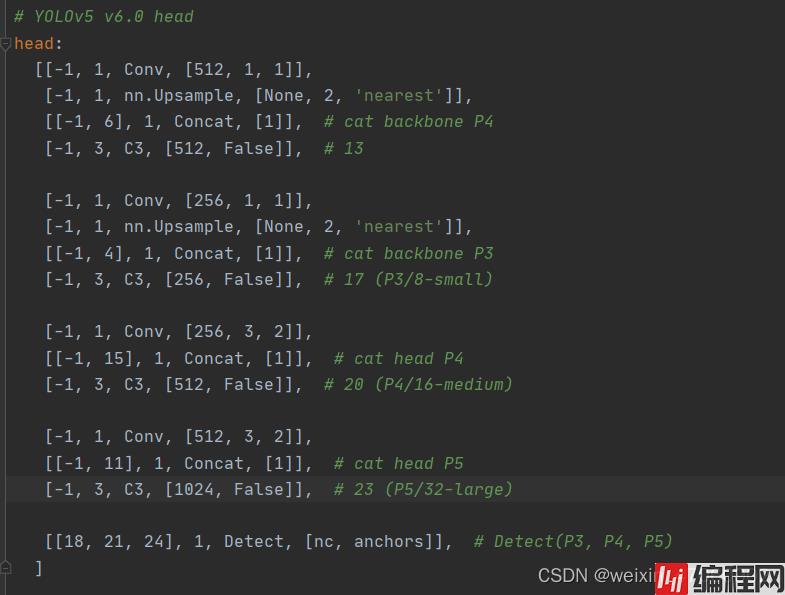

然后head部分也要进行相应的修改,因为我们多加了一层,所以需要保持head以及最后的输出层不变就得稍微改一下head部分,同样,注意力机制也可以放在head里面,跟加在backbone里面的方法相同。

这是原始的head部分,需要修改成下面这样

因为我们把SE注意力机制插在第八层之后,所以原先的14层就变成了15层,同样的,最后的输出也需要把层数加一。

添加这些注意力机制是yolov5最基础的改进,但是说实话,注意力机制可以添加在很多的地方,不一定会有效果,所以插在哪里效果最好就需要大家自行讨论了。 注意力机制也有很多种,se注意力机制应该是属于最基础的通道注意力了吧

总结

到此这篇关于YOLOv5改进教程之添加注意力机制的文章就介绍到这了,更多相关YOLOv5添加注意力机制内容请搜索编程网以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程网!

--结束END--

本文标题: YOLOv5改进教程之添加注意力机制

本文链接: https://lsjlt.com/news/152693.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0