Python 官方文档:入门教程 => 点击学习

目录目标光流OpenCV 中的 Lucas-Kanade 光流OpenCV 中的密集光流目标 在本章中,将学习: 使用 Lucas-Kanade 方法理解光流的概念及其估计使用cv2

在本章中,将学习:

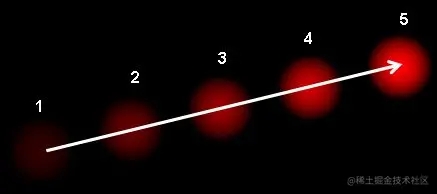

cv2.calcOpticalFlowPyrLK()等函数来跟踪视频中的特征点cv2.calcOpticalFlowFarneback()方法创建一个密集的光流场光流是由物体或相机的运动引起的图像物体在两个连续帧之间的明显运动的模式。它是二维向量场,其中每个向量都是一个位移向量,显示点从第一帧到第二帧的移动。如下图所示。

它显示了一个球在连续 5 帧中移动。箭头表示其位移矢量。光流在以下领域有许多应用:

光流基于以下几个假设:

(用 Harris 角点检测器检查逆矩阵的相似性。它表示角点是更好的跟踪点。)

所以从用户的角度来看,这个想法很简单,给出了一些要追踪的要点,收到了这些点的光学流量矢量。但是,还有一些问题。到目前为止,正在处理的是小的动作,因此当有很大的动作时它失败了。要处理这一点,需要使用金字塔。当在金字塔上采样时,会消除小型动作,大的运动会变小。因此,通过在那里应用Lucas-Kanade,将光流与缩放合在一起了。

OpenCV的cv2.calcOpticalFlowPyrLK() 提供了所有这些功能。下面创建一个简单的应用程序来跟踪视频中的某些点。为了确定点,使用cv2.GoodFeaturesToTrack()。取第一帧,检测其中的一些 Shi-Tomasi 角点,然后使用 Lucas-Kanade 光流迭代跟踪这些点。对于函数cv2.calcOpticalFlowPyrLK(),传递前一帧、前面的点和下一帧。它返回之后的点以及一些状态编号,如果找到之后的点,则值为 1,否则为零。在下一步中迭代地将这些点作为前面的点传递,迭代进行。

import cv2

import numpy as np

video_file = 'slow_traffic_small.mp4'

cap = cv2.VideoCapture(video_file)

# params for ShiTomasi corner detection

feature_params = dict( maxCorners = 100,

qualityLevel = 0.3,

minDistance = 7,

blockSize = 7 )

# Parameters for lucas kanade optical flow

lk_params = dict(

winSize = (15, 15),

maxLevel = 2,

criteria = (cv2.TERM_CRITERIA_EPS | cv2.TERM_CRITERIA_COUNT, 10, 0.03))

# create some random colors

color = np.random.randint(0, 255, (100, 3))

# Take first frame and find corners in it

ret, old_frame = cap.read()

old_gray = cv2.cvtColor(old_frame, cv2.COLOR_BGR2GRAY)

p0 = cv2.goodFeaturesToTrack(old_gray, mask=None, **feature_params)

# create a mask image for drawing purpose

mask = np.zeros_like(old_frame)

while True:

ret, frame = cap.read()

if ret:

frame_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# calculate optical flow

p1, st, err = cv2.calcOpticalFlowPyrLK(old_gray, frame_gray, p0, None, **lk_params)

# Select good points

if p1 is not None:

good_new = p1[st==1]

good_old = p0[st==1]

# draw the tracks

for i,(new, old) in enumerate(zip(good_new, good_old)):

a, b = new.ravel()

c, d = old.ravel()

mask = cv2.line(mask, (int(a), int(b)), (int(c), int(d)), color[i].tolist(), 2)

frame = cv2.circle(frame, (int(a), int(b)), 5, color[i].tolist(), -1)

img = cv2.add(frame,mask)

cv2.imshow('frame',img)

k = cv2.waiTKEy(30) & 0xff

if k == 27:

cv2.destroyAllwindows()

break

# Now update the previous frame and previous points

old_gray = frame_gray.copy()

p0 = good_new.reshape(-1,1,2)

else:

cv2.destroyAllWindows()

break

上述代码没有检查下一个关键点的正确程度。因此,即使图像中任何一个特征点消失,光流也有可能找到下一个看起来可能靠近它的点。实际上, 对于稳健的跟踪,角点应该在特定的时间间隔内检测点。OpenCV sample提出了这样一个例子,它每 5 帧找到一次特征点,还运行对光流点的向后检查,只选择好的点 )。代码见(GitHub.com/opencv/open…)

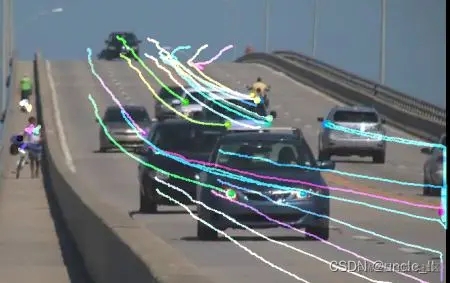

结果如下:

Lucas-Kanade 方法计算稀疏特征集的光流(在示例中,使用 Shi-Tomasi 算法检测到的角点)。OpenCV 提供了另一种算法来寻找密集光流。它计算帧中所有点的光流。它基于 Gunner Farneback 的算法,该算法在 Gunner Farneback 于 2003 年在“Two-Frame Motion Estimation Based on Polynomial Expansion”中进行了解释。

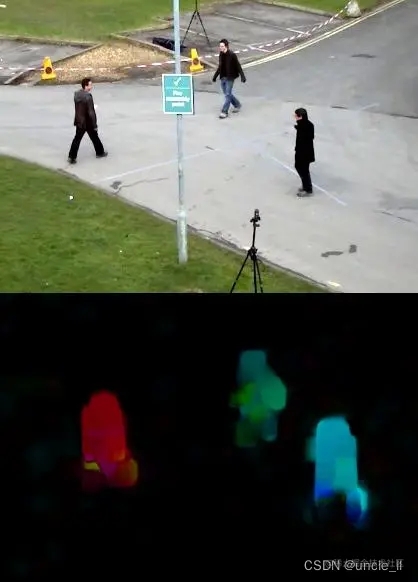

下面的示例显示了如何使用上述算法找到密集光流。首先得到一个带有光流向量(u,v)(u,v)(u,v)的 2通道向量,找到它们的大小和方向。对结果进行颜色编码以实现更好的可视化。方向对应于图像的色调值(Hue),幅度对应于值屏幕。代码如下:

import cv2

import numpy as np

cap = cv2.VideoCapture("vtest.avi")

ret, frame1 = cap.read()

frame1_gray = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(frame1)

hsv[...,1] = 255

while(1):

ret, frame2 = cap.read()

if ret:

frame2_gray = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

flow = cv2.calcOpticalFlowFarneback(frame1_gray, frame2_gray, None, 0.5, 3, 15, 3, 5, 1.2, 0)

mag, ang = cv2.cartToPolar(flow[...,0], flow[...,1])

hsv[...,0] = ang*180/np.pi/2

hsv[...,2] = cv2.nORMalize(mag, None, 0, 255, cv2.NORM_MINMAX)

bgr = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

cv2.imshow('frame2', bgr)

k = cv2.waitKey(30) & 0xff

if k == 27:

cv2.destroyAllWindows()

break

elif k == ord('s'):

cv2.imwrite('opticalfb.png',frame2)

cv2.imwrite('opticalhsv.png',bgr)

frame1_gray = frame2_gray

else:

cv2.destroyAllWindows()

break

附加资源

以上就是OpenCV 光流Optical Flow示例的详细内容,更多关于OpenCV 光流Optical Flow的资料请关注编程网其它相关文章!

--结束END--

本文标题: OpenCV 光流Optical Flow示例

本文链接: https://lsjlt.com/news/211844.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0