这篇文章主要介绍“TextFile分区问题怎么理解”,在日常操作中,相信很多人在TextFile分区问题怎么理解问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”TextFile

这篇文章主要介绍“TextFile分区问题怎么理解”,在日常操作中,相信很多人在TextFile分区问题怎么理解问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”TextFile分区问题怎么理解”的疑惑有所帮助!接下来,请跟着小编一起来学习吧!

val rdd1 = sc.parallelize(List(2,3,4,1,7,5,6,9,8))

获取分区的个数:rdd1.partitions.length,在spark-shell中没有指定分区的个数获取的是默认分区数,除了这个外parallelize方法可以使用,指定几个分区就会有几个分区出现

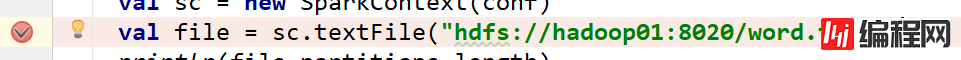

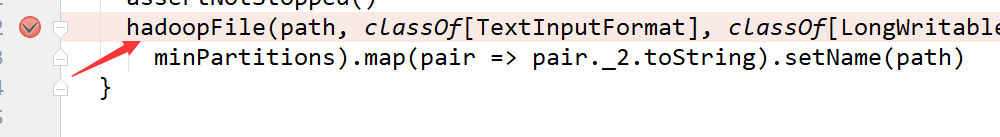

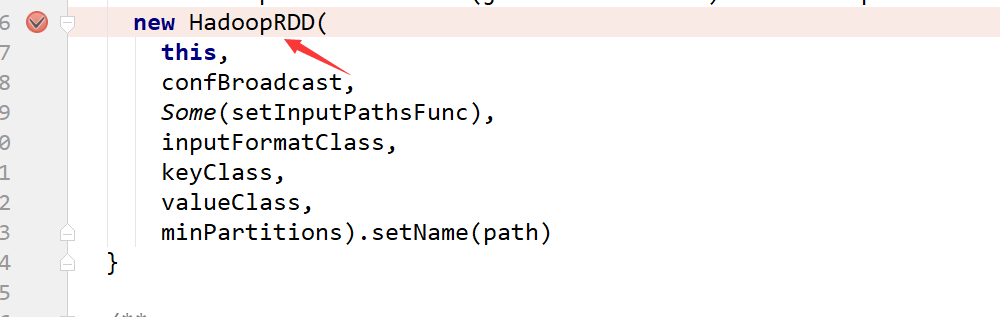

val rdd1 = sc.textFile("hdfs://hadoop02:8020/Word.txt",3).flatMap _.split('')).map((_,1)).reduceByKey(_+_)

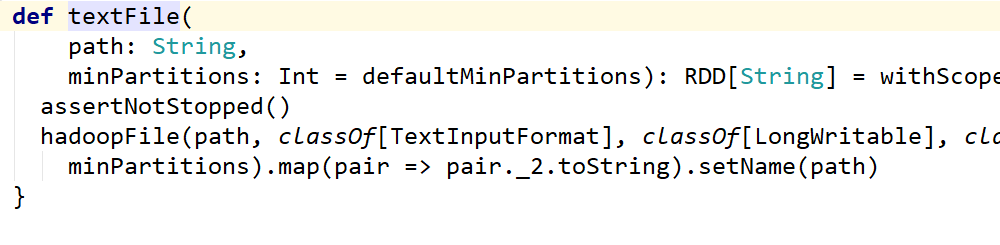

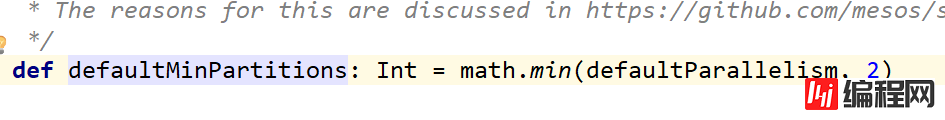

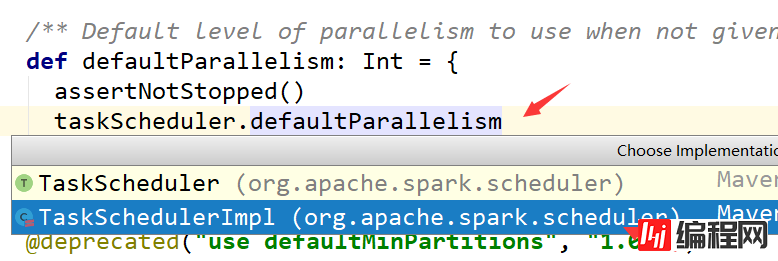

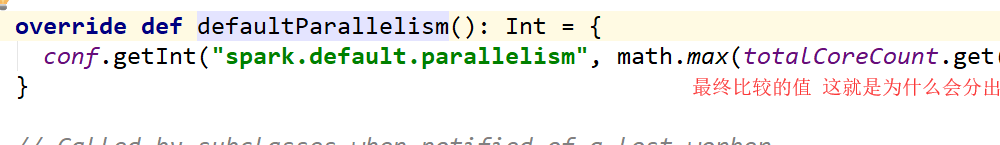

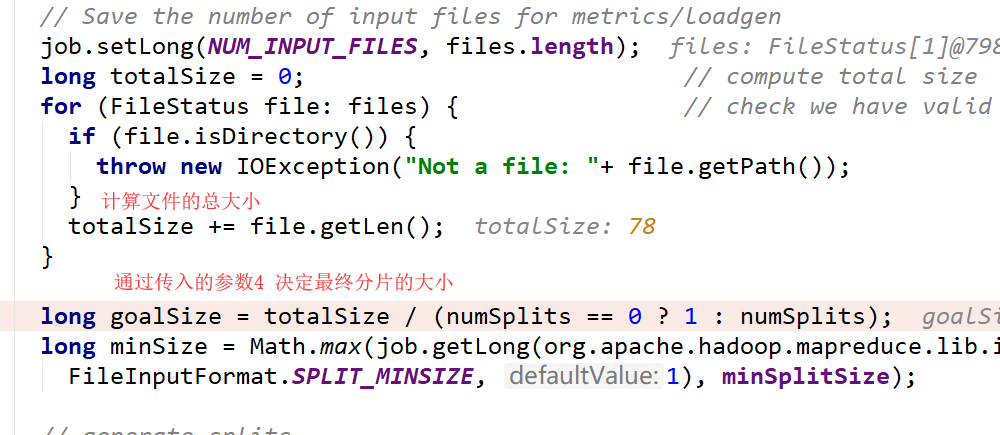

textFile这个方法是有默认值就是2 除非改变loacl中的即默认值这个只要这个默认值小于2的话会使用小于默认的值

这个默认属性是有值的defaultMinPartitions

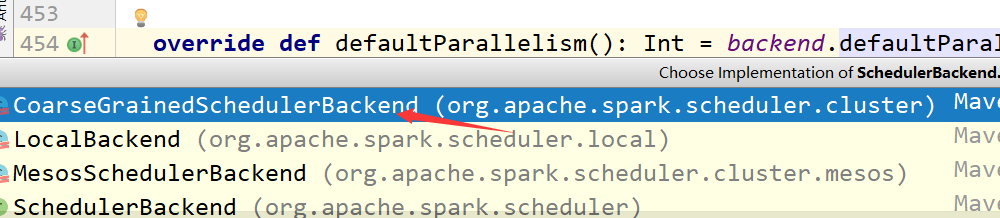

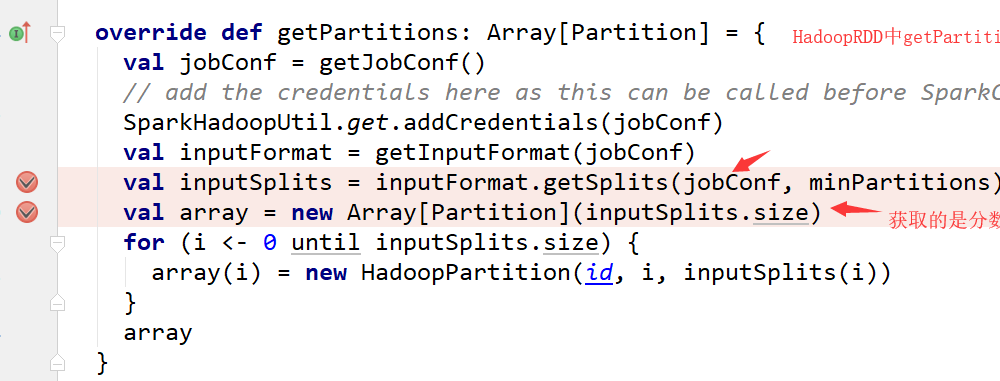

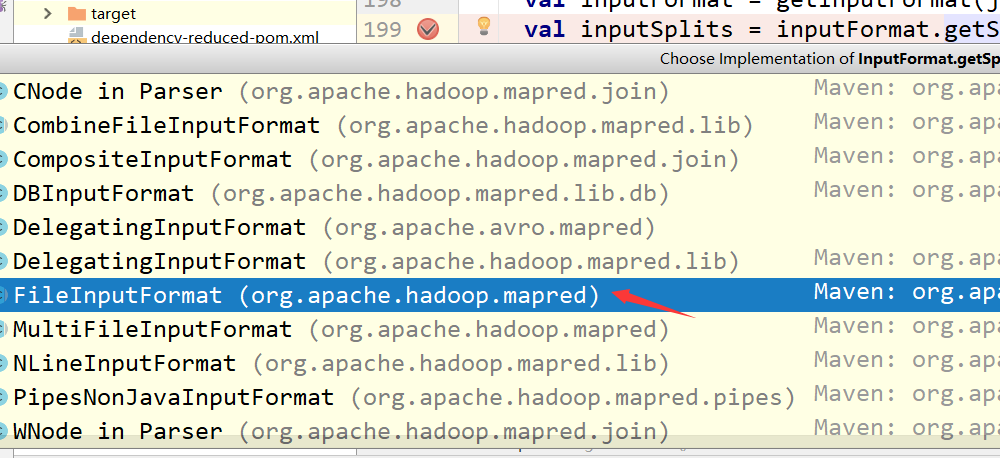

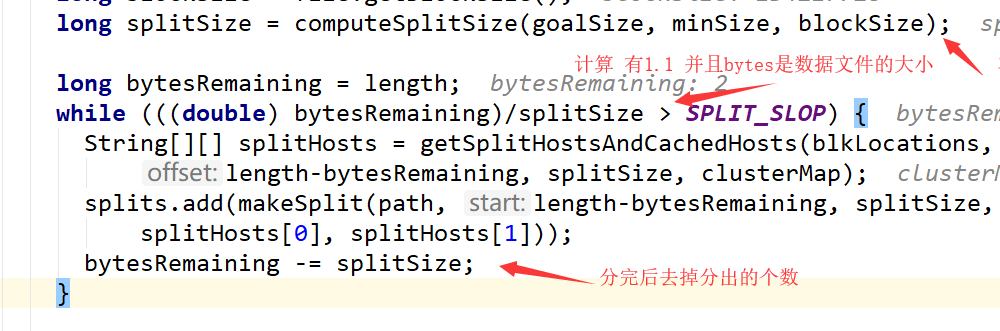

如果在textfile中传入了分区数,那么这个分区数可能相同也可能不同需要看底层计算!

到此,关于“TextFile分区问题怎么理解”的学习就结束了,希望能够解决大家的疑惑。理论与实践的搭配能更好的帮助大家学习,快去试试吧!若想继续学习更多相关知识,请继续关注编程网网站,小编会继续努力为大家带来更多实用的文章!

--结束END--

本文标题: TextFile分区问题怎么理解

本文链接: https://lsjlt.com/news/70228.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-10-23

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0