【摘要】 Sqoop是一种用于在 Apache hadoop 和结构化数据存储(如关系数据库)之间高效传输批量数据的工具 。本文将简单介绍Sqoop作业执行时相关的类及方法,并将该过程与map

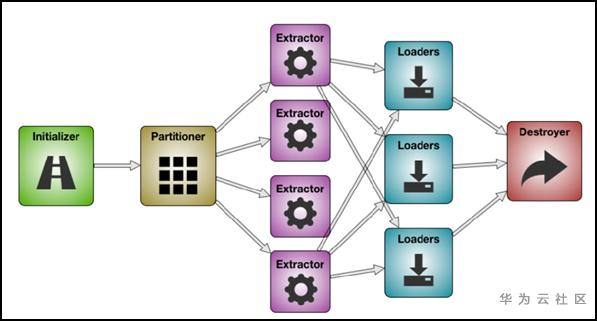

【摘要】 Sqoop是一种用于在 Apache hadoop 和结构化数据存储(如关系数据库)之间高效传输批量数据的工具 。本文将简单介绍Sqoop作业执行时相关的类及方法,并将该过程与mapReduce的执行结合,分析数据如何从源端迁移到目的端。

public abstract void initialize(InitializerContext context, LinkConfiguration linkConfiguration,JobConfiguration jobConfiguration); public List getJars(InitializerContext context, LinkConfiguration linkConfiguration,JobConfiguration jobConfiguration){ return new LinkedList(); } public abstract Schema getSchema(InitializerContext context, LinkConfiguration linkConfiguration,JobConfiguration jobConfiguration) { return new NullSchema(); } 其中getSchema()方法被From或者To端的connector在提取或者载入数据时用来匹配数据。例如,一个GenericJdbcConnector会调用它获取源端Mysql的数据库名,表名,表中的字段信息等。

public abstract void destroy(DestroyerContext context, LinkConfiguration linkConfiguration,JobConfiguration jobConfiguration);public abstract List getPartitions(PartitionerContext context, LinkConfiguration linkConfiguration, FromJobConfiguration jobConfiguration);

Partition类中实现了readFields()方法和write()方法,方便读写 public abstract class Partition { public abstract void readFields(Datainput in) throws IOException; public abstract void write(DataOutput out) throws IOException; public abstract String toString(); }while (resultSet.next()) { ... context.getDataWriter().writeArrayRecord(array); ... }while ((array = context.getDataReader().readArrayRecord()) != null) { ... } Mapper

2)作业执行阶段的Mapper过程

Mapper

2)作业执行阶段的Mapper过程

private Class SqoopMapDataWriter extends DataWriter { ... private void writeContent() { ... context.wirte(writable, NullWritable.get()); // 这里的writable 是SqoopWritable的一个对象 ... } ... }注意:这里的Context中存的是KV对,K是SqoopWritable,而V仅是一个空的Writable对象。SqoopWritable中实现了write和readField,用于序列化和反序列化。

Reducer

3)作业执行阶段的Reduce过程,

Reducer

3)作业执行阶段的Reduce过程,

public RecordWriter getRecordWriter() { executorService = Executors.newSingleThreadExecutor(...); consumerFuture = executorService.submit(new ConsumerThread(context)); return writer; } private class ConsumerThread implements Runnable { ... public void run() { ... Loader.load(loaderContext, connectorLinkConfig, ConnectorToJobConfig); ... } ... }

注意

:

注意

:

--结束END--

本文标题: 深入浅出Sqoop之迁移过程源码分析

本文链接: https://lsjlt.com/news/6303.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-10-23

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0