文章目录 1.安装环境及软件准备1.1环境 2.准备工作3.安装DolphinScheduler3.1DolphinSchedule源数据库配置3.2DolphinScheduler配置及

JDK1.8+ JDK安装

所有节点都要有jdk环境,这里不详细介绍,网上资料很多

Mysql/PostgreSQL

这里使用的msyql,Mysql版本必须是5.1.47+,mysql的安装包及安装部署之前的博客有提到,CentOS7.9离线安装mysql

Zookeeper集群

这里不详细介绍,网上资料很多

DolphinScheduler软件

提取码: wriv

节点间免密配置和域名映射

之前写过了,这里就不详细写了可以在,Ambari-2.7.4和HDP-3.1.4安装博客中查看对应的步骤

创建数据库

在安装mysql的节点创建Dolphin的元数据库

mysql> CREATE DATABASE dolphinscheduler DEFAULT CHARACTER SET utf8 DEFAULT COLLATE utf8_general_ci; -- 创建数据库并指定编码格式开启权限

-- 赋权mysql> GRANT ALL PRIVILEGES ON dolphinscheduler.* TO '用户名'@'%' IDENTIFIED BY '密码';-- 如果提示'Your password does not satisfy the current policy requirements'就说明这个密码不符当前的密码策略,可以执行如下命令mysql> set global validate_password_policy=LOW; -- 验证密码等级强度mysql> set global validate_password_length=6; -- 设置密码长度mysql> flush privileges; -- 刷新权限先将Dolphin安装包上传解压

tar -zxf apache-dolphinscheduler-2.0.0-alpha-bin.tar.gz # 解压安装包增加mysql驱动

# 将mysql驱动放到Dolphin的lib目录下mv ./mysql-connector-java-5.1.44.jar ./apache-dolphinscheduler-2.0.0-alpha-bin/lib__提取码:__f464

修改conf目录下的datasource.properties配置文件]

vi datasource.properties#修改内容如下# datasource configuration#spring.datasource.driver-class-name=org.postgresql.Driver#spring.datasource.url=jdbc:postgresql://127.0.0.1:5432/dolphinscheduler#spring.datasource.username=root#spring.datasource.passWord=root# mysql 因为这里使用的mysql作为元数据库,所以要将上面postgresql的配置注释掉spring.datasource.driver-class-name=com.mysql.jdbc.Driverspring.datasource.url=jdbc:mysql://lx01:3306/dolphinscheduler?characterEncoding=UTF-8&allowMultiQueries=truespring.datasource.username=用户名spring.datasource.password=密码#保存退出即可执行脚本初始化元数据

dolphin已经为我们准备了初始化元数据库的脚本,执行script目录下的create-dolphinscheduler.sh脚本即可

./create-dolphinscheduler.sh# 如果在部署完所有的步骤后,访问DolphinScheduler界面创建项目时,发现提示元数据库缺少字段,可以不通过create-dolphinscheduler.sh这个脚本初始化元数据库,可以将/opt/apps/apache-dolphinscheduler-2.0.0-alpha-bin/sql这个目录下的dolphinscheduler_mysql.sql这个文件在mysql中直接执行用来创建元数据表,在mysql中执行命令:source //opt/apps/apache-dolphinscheduler-2.0.0-alpha-bin/dolphinscheduler_mysql.sql执行完成后移可以去我们已经在mysql建立的dolphinscheduler库中查看一下

mysql> show tables;+----------------------------------------+| Tables_in_dolphinscheduler |+----------------------------------------+| QRTZ_BLOB_TRIGGERS || QRTZ_CALENDARS || QRTZ_CRON_TRIGGERS || QRTZ_FIRED_TRIGGERS || QRTZ_JOB_DETaiLS || QRTZ_LOCKS || QRTZ_PAUSED_TRIGGER_GRPS || QRTZ_SCHEDULER_STATE || QRTZ_SIMPLE_TRIGGERS || QRTZ_SIMPROP_TRIGGERS || QRTZ_TRIGGERS || t_ds_access_token || t_ds_alert || t_ds_alert_plugin_instance || t_ds_alertgroup || t_ds_command || t_ds_datasource || t_ds_environment || t_ds_environment_worker_group_relation || t_ds_error_command || t_ds_master_server || t_ds_plugin_define || t_ds_process_definition |-- 这里就不全部展示了这里用到什么组件就修改什么就可了,没有使用到的组件可直接注释掉,修改/conf/env目录下的dolphinscheduler_env.sh配置文件

vi ./dolphinscheduler_env.sh# 文件内容如下:export hadoop_HOME=/opt/apps/hadoop-3.1.1export HADOOP_CONF_DIR=/opt/apps/hadoop-3.1.1/etc/hadoop#export spark_HOME1=/opt/soft/spark1export SPARK_HOME2=/opt/apps/spark-3.0#export python_HOME=/opt/soft/Pythonexport JAVA_HOME=/opt/apps/jdk1.8export Hive_HOME=/opt/apps/hive-3.1.2#export flink_HOME=/opt/soft/flink#export DATAX_HOME=/opt/soft/dataxexport PATH=$HADOOP_HOME/bin:$SPARK_HOME2/bin:$JAVA_HOME/bin:$HIVE_HOME/bin:$PATH修改/conf/config目录下的install_config.conf配置文件

vi ./install_config.conf# 文件内容如下## Licensed to the Apache Software Foundation (ASF) under one or more# contributor license agreements. See the NOTICE file distributed with# this work for additional infORMation regarding copyright ownership.# The ASF licenses this file to You under the Apache License, Version 2.0# (the "License"); you may not use this file except in compliance with# the License. You may obtain a copy of the License at## Http://www.apache.org/licenses/LICENSE-2.0## Unless required by applicable law or agreed to in writing, software# distributed under the License is distributed on an "AS IS" BASIS,# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.# See the License for the specific language Governing permissions and# limitations under the License.## ---------------------------------------------------------# INSTALL MacHINE# ---------------------------------------------------------# Dolphin服务所要部署的节点,ips后面可加主机名或者直接加ip地址ips="lx01,lx02,lx03"# ssh端口号,一般默认为22,不用修改sshPort="22"# master服务所在节点masters="lx01,lx02"# worker服务所在节点,并指定所属worker组,这里指定default组workers="lx01:default,lx02:default,lx03:default"# alter服务(报警服务)所在节点,单节点就可以alertServer="lx03"# api服务(后端api服务)所在节点,单节点就可以apiServers="lx01"# DS安装位置,三个节点都要有这个目录installPath="/opt/apps/dolphinscheduler"# 使用哪个用户进行安装部署,这里就直接使用root,如果使用别的用户进行安装部署需要对该用户进行授权deployUser="root"# DolphinScheduler本地数据的存储目录,三个节点都要有这个目录dataBasedirPath="/opt/data/dolphin"# JAVA环境变量的物理路径javaHome="/opt/apps/jdk1.8"# API后端服务的端口号同时也是WEB页面访问的端口号,根据实际需求进行配置apiServerPort="12345"# 所使使用的数据库类型,选择mysql或者postgresql,这里使用mysqldbtype="mysql"# mysql服务所在节点及端口号dbhost="lx01:3306"# mysql的用户名username="用户名"# mysql的密码password="密码"# 在mysql中所使用的库名,就是之前已经配置好的dolphin的元数据库dbname="dolphinscheduler"# 注册服务插件jar包位置,这个默认即可reGIStryPluginDir="lib/plugin/registry/ZooKeeper"# 注册服务名称,默认即可registryPluginName="zookeeper"# 注册服务位置,将ip地址换成zoopeeker集群的位置即可,可以写ip地址或者主机名registryServers="lx01:2181,lx02:2181,lx03:2181"# Dolphin在zookeeper中注册的位置,默认即可zkRoot="/dolphinscheduler"# 警报服务插件jar包位置,默认即可alertPluginDir="lib/plugin/alert"# 任务调度插件jar包位置,默认即可taskPluginDir="lib/plugin/task"# 资源存储类型: hdfs, S3, NONE,这里选择hdfs,如果选择NONE则是使用本地文件系统resourceStorageType="HDFS"# 资源存储位置,因为上面选择的存储类型是HDFS,这个路径就是HDFS上的路径,要确保存在这个路径,并且Dolphin具备读写权限resourceUploadPath="/dolphinscheduler"# 默认文件系统,如果选择了HDFS并且HDFS已经开启了HA那么就要将core-site.xml和hdfs-site.xml放入到conf目录下defaultFS="hdfs://lx01:8020"# 没有使用到s3,这个就可以注释掉,如果使用的s3再另行配置# s3Endpoint="http://192.168.xx.xx:9010"# s3AccessKey="xxxxxxxxxx"# s3SecreTKEy="xxxxxxxxxx"# yarn的resourcemanager http端口号resourceManagerHttpAddressPort="8088"# 如resourcemanager HA启用,则配置为ResourceManager节点的主备ip或者hostname,比如"192.168.xx.xx,192.168.xx.xx";如果是单ResourceManager请配置yarnHaIps=""即可yarnHaIps="192.168.xx.xx,192.168.xx.xx"# 如果ResourceManager是HA或者没有使用到Yarn保持默认值"yarnIp1"即可;如果是单ResourceManager,请配置真实的ResourceManager主机名或者ipsingleYarnIp="lx01"# 使用哪个用户对hdfs文件系统进行操作,一般我们要选一个权限比较高的hdfsRootUser="hdfs"# 关于kerberos根据实际情况配置即可,如果开启了kerberos就根据实际情况配置,没有开启则不用动# kerberos config# whether kerberos starts, if kerberos starts, following four items need to config, otherwise please ignorekerberosStartUp="false"# kdc krb5 config file pathkrb5ConfPath="$installPath/conf/krb5.conf"# keytab username,watch out the @ sign should followd by \\keytabUserName="hdfs-mycluster\\@ESZ.COM"# username keytab pathkeytabpath="$installPath/conf/hdfs.headless.keytab"# kerberos expire time, the unit is hourkerberosExpireTime="2"# 是否使用sudo,默认为true就可sudoEnable="true"# 工作租户自动创建,默认为false即可workerTenantAutoCreate="false"执行apache-dolphinscheduler-2.0.0-alpha-bin目录下的install.sh脚本进行安装部署

./install.sh安装完成后DolphinScheduler会自动启动,可通过jps命令查看服务是否已经启动

jps3475 QuorumPeerMain5571 MasterServer # Master服务5877 Jps3703 Namenode3848 DataNode4457 NodeManager5657 LoggerServer # 日志服务4858 JobHistoryServer5707 ApiApplicationServer # Api服务4302 ResourceManager5615 WorkerServer # Worker服务URL

ip地址:12345/dolphinscheduler

默认用户

admin

默认密码

dolphinscheduler123

登录界面如下

![[外链图片转存中...(img-LtIeJT4J-1660130725324)]](https://file.lsjlt.com/upload/f/202309/12/tgzlp2wo2su.png)

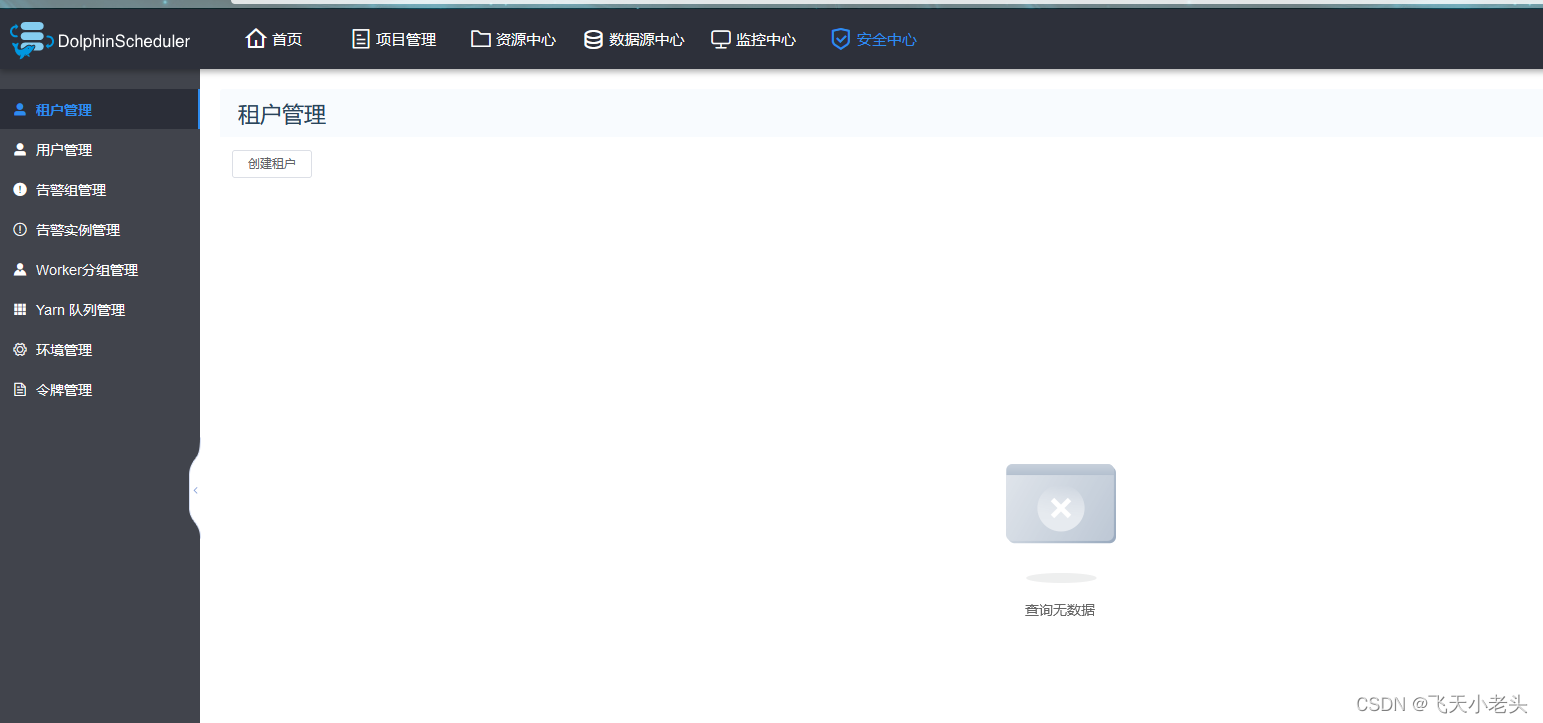

操作界面如下

到这里DolphinScheduler的安装部署就完成了,接下来我们就可以进行上使用了.

来源地址:https://blog.csdn.net/AnameJL/article/details/126272946

--结束END--

本文标题: DolphinScheduler安装部署

本文链接: https://lsjlt.com/news/404962.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-10-23

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

2024-10-22

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0