这篇文章主要介绍了PyTorch中Tensor.to(device)和model.to(device)的区别是什么的相关知识,内容详细易懂,操作简单快捷,具有一定借鉴价值,相信大家阅读完这篇pytorch中Tensor.to(device)

这篇文章主要介绍了PyTorch中Tensor.to(device)和model.to(device)的区别是什么的相关知识,内容详细易懂,操作简单快捷,具有一定借鉴价值,相信大家阅读完这篇pytorch中Tensor.to(device)和model.to(device)的区别是什么文章都会有所收获,下面我们一起来看看吧。

使用GPU训练的时候,需要将Module对象和Tensor类型的数据送入到device。通常会使用 to.(device)。但是需要注意的是:

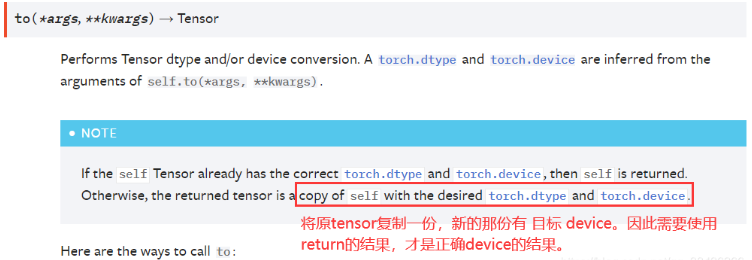

对于Tensor类型的数据,使用to.(device) 之后,需要接收返回值,返回值才是正确设置了device的Tensor。

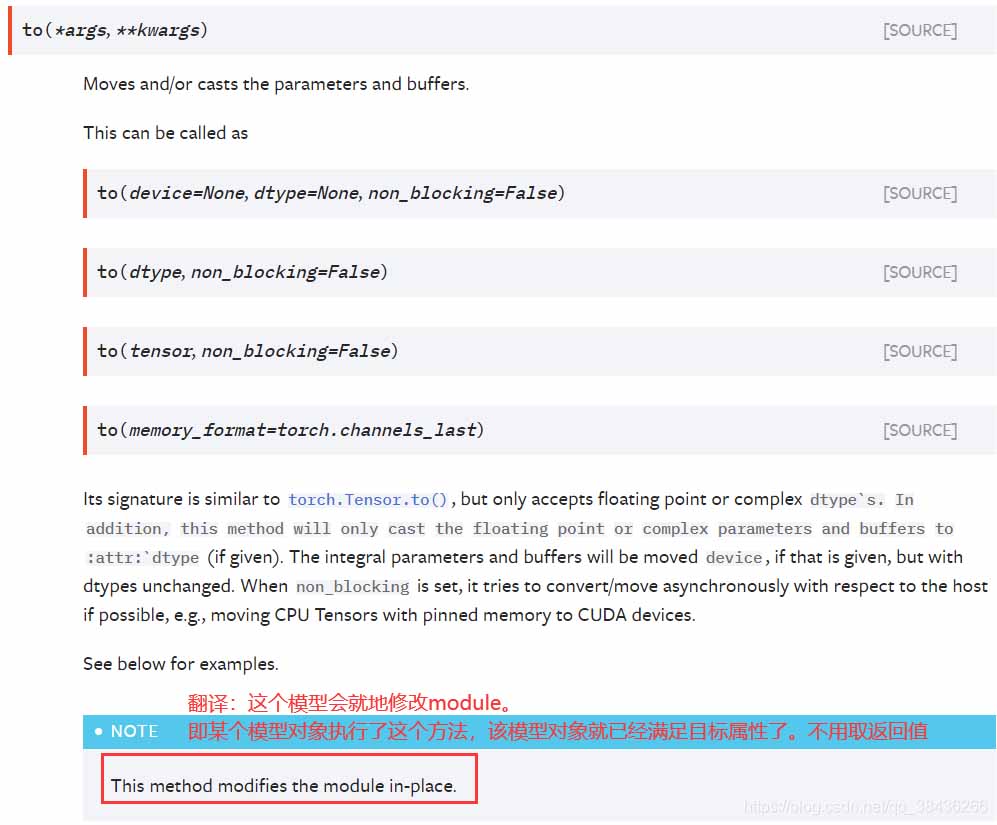

对于Module对象,只用调用to.(device) 就可以将模型设置为指定的device。不必接收返回值。

来自pytorch官方文档的说明:

Tensor.to(device)

Module.to(device)

# Module对象设置device的写法model.to(device)# Tensor类型的数据设置 device 的写法。samples = samples.to(device)img = img.to(device=torch.device("cuda" if torch.cuda.is_available() else "cpu"))model = models.vgg16_bn(pretrained=True).to(device=torch.device("cuda" if torch.cuda.is_available() else "cpu"))也可以先定义device:

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")model = model.to(device)img = img.to(device)这段代码的意思就是将所有最开始读取数据时的tensor变量copy一份到device所指定的GPU上去,之后的运算都在GPU上进行。

首先,在做高维特征运算的时候,采用GPU无疑是比用CPU效率更高,如果两个数据中一个加了.cuda()或者.to(device),而另外一个没有加,就会造成类型不匹配而报错。

tensor和numpy都是矩阵,前者能在GPU上运行,后者只能在CPU运行,所以要注意数据类型的转换。

两个方法都可以达到同样的效果,在pytorch中,即使是有GPU的机器,它也不会自动使用GPU,而是需要在程序中显示指定。调用model.cuda(),可以将模型加载到GPU上去。这种方法不被提倡,而建议使用model.to(device)的方式,这样可以显示指定需要使用的计算资源,特别是有多个GPU的情况下。

那么可以参考以下代码:

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")model = Model()if torch.cuda.device_count() > 1: model = nn.DataParallel(model,device_ids=[0,1,2]) model.to(device)关于“pytorch中Tensor.to(device)和model.to(device)的区别是什么”这篇文章的内容就介绍到这里,感谢各位的阅读!相信大家对“pytorch中Tensor.to(device)和model.to(device)的区别是什么”知识都有一定的了解,大家如果还想学习更多知识,欢迎关注编程网精选频道。

--结束END--

本文标题: pytorch中Tensor.to(device)和model.to(device)的区别是什么

本文链接: https://lsjlt.com/news/343697.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0