Python 官方文档:入门教程 => 点击学习

requests.gpython用requests.get获取网页内容为空的问题怎么解决,针对这个问题,这篇文章详细介绍了相对应的分析和解答,希望可以帮助更多想解决这个问题的小伙伴找到更简单易行的方法。下面先来看一个例子:import&nb

requests.gpython用requests.get获取网页内容为空的问题怎么解决,针对这个问题,这篇文章详细介绍了相对应的分析和解答,希望可以帮助更多想解决这个问题的小伙伴找到更简单易行的方法。

下面先来看一个例子:

import requestsresult=requests.get("Http://data.10jqka.com.cn/financial/yjyg/")result输出结果:

表示成功处理了请求,一般情况下都是返回此状态码; 报200代表没问题

继续运行,发现返回空值,在请求网页爬取的时候,输出的text信息中会出现抱歉,无法访问等字眼,这就是禁止爬取,需要通过反爬机制去解决这个问题。headers是解决requests请求反爬的方法之一,相当于我们进去这个网页的服务器本身,假装自己本身在爬取数据。对反爬虫网页,可以设置一些headers信息,模拟成浏览器取访问网站 。

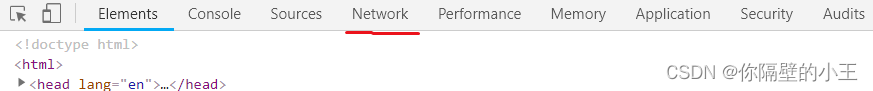

拿两个常用的浏览器举例:

界面 F12

点击network 键入 CTRL+R

单击第一个 最下边就是我门需要的 把他设置成headers解决问题

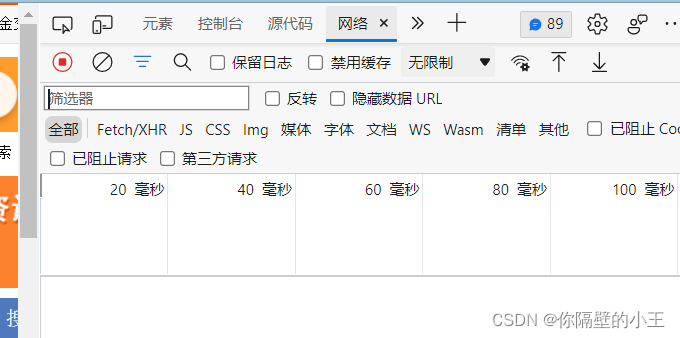

同样 F12 打开开发者工具

点击网络,CTRL+R

前文代码修改:

import requestsur="http://data.10jqka.com.cn/financial/yjyg/"headers = {'User-Agent': 'Mozilla/5.0 (windows NT 10.0; WOW64) AppleWEBKit/537.36 (Khtml, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3880.400 QQBrowser/10.8.4554.400 '}result = requests.get(ur, headers=headers)result.text成功解决不能爬取问题。

关于requests.gPython用requests.get获取网页内容为空的问题怎么解决问题的解答就分享到这里了,希望以上内容可以对大家有一定的帮助,如果你还有很多疑惑没有解开,可以关注编程网Python频道了解更多相关知识。

--结束END--

本文标题: requests.gPython用requests.get获取网页内容为空的问题怎么解决

本文链接: https://lsjlt.com/news/306712.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0