这篇文章给大家介绍基于DF的Tokenizer分词是怎么样的,内容非常详细,感兴趣的小伙伴们可以参考借鉴,希望对大家能有所帮助。Tokenizer分词进行文本分析前,对文本中句子进行分词我们处理的第一步。大家都是spark的机器学习库分为基

这篇文章给大家介绍基于DF的Tokenizer分词是怎么样的,内容非常详细,感兴趣的小伙伴们可以参考借鉴,希望对大家能有所帮助。

Tokenizer分词

进行文本分析前,对文本中句子进行分词我们处理的第一步。大家都是spark的机器学习库分为基于RDD和基于DataFrame的库,由于基于RDD的库在Spark2.0以后都处于维护状态,我们这里讲的分词就是基于Spark的Dataframe的。主要是讲解两个类Tokenizer和RegexTokenizer的使用。

1 首先准备数据

导包

import org.apache.spark.ml.feature.{RegexTokenizer, Tokenizer}

import org.apache.spark.sql.functions._

准数据

val sentenceDataFrame = spark.createDataFrame(Seq(

(0, "Hi I heard about Spark"),

(1, "I wish Java could use case classes"),

(2, "LoGIStic,regression,models,are,neat")

)).toDF("id", "sentence")

2 Tokenizer

Tokenizer负责读取文档或者句子,将其分解为单词。声明一个变量

val tokenizer = new Tokenizer().setInputCol("sentence").setOutputCol("Words")

自定义函数来获取每列单词数目

val countTokens = udf { (words: Seq[String]) => words.length }

调用转换函数

val tokenized = tokenizer.transfORM(sentenceDataFrame)

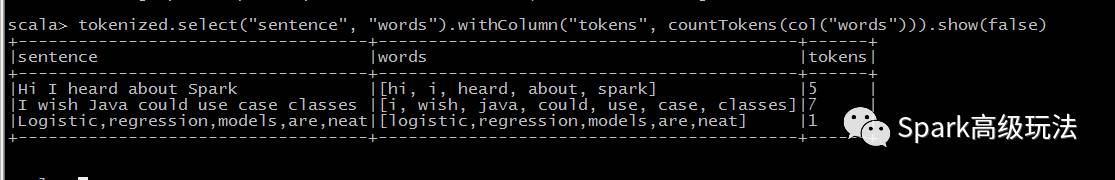

tokenized.select("sentence", "words").withColumn("tokens", countTokens(col("words"))).show(false)

3 RegexTokenizer

RegexTokenizer允许基于正则的方式进行文档切分成单词组。默认情况下,使用参数“pattern”( regex, default: "\s+")作为分隔符来分割输入文本。或者,用户可以将参数“gaps”设置为false,指示正则表达式“pattern”表示“tokens”,而不是分割间隙,并查找所有匹配事件作为切分后的结果。

val regexTokenizer = new RegexTokenizer().setInputCol("sentence").setOutputCol("words").setPattern("\W")

// 也可换为 .setPattern("\w+").setGaps(false)

开始转换并查看执行结果

val regexTokenized = regexTokenizer.transform(sentenceDataFrame)

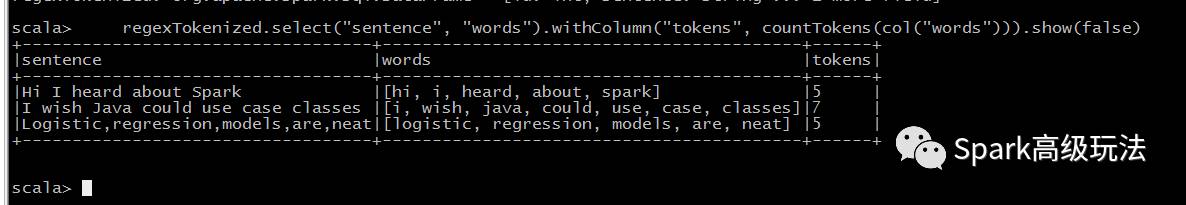

regexTokenized.select("sentence", "words").withColumn("tokens", countTokens(col("words"))).show(false)

关于基于DF的Tokenizer分词是怎么样的就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看到。

--结束END--

本文标题: 基于DF的Tokenizer分词是怎么样的

本文链接: https://lsjlt.com/news/295599.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

2024-05-24

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0