今天上午在没事儿爬一下我自己的博客主页文章练习下。在写入的时候遇到的编码问题,折腾了半天 ,记录一下

import urllib.request

import time

str1 = urllib.request.urlopen('https://www.cnblogs.com/thelovelybugfly/').read().decode('utf-8')

url = ['']*10

i = 0

title = str1.find(r'postTitle2')

href = str1.find(r'href', title)

html = str1.find(r'.html', title)

while title != -1 and href != -1 and html != -1 and i < 40:

url[i] = str1[href + 6:html + 5]

print(url[i])

title = str1.find(r'postTitle2', html)

href = str1.find(r'href', title)

html = str1.find(r'.html', title)

i = i + 1

else:

print("find over")

j = 0

while j < 10:

pagename = urllib.request.urlopen(url[j]).read().decode('utf-8')

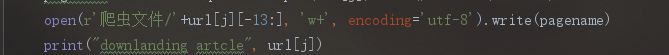

open(r'爬虫文件/'+url[j][-13:], 'w+').write(pagename)

print("downlanding artcle", url[j])

j = j + 1

time.sleep(2)

else:

print("download finish")

出现这个问题, 换了各种编码还是没解决, 后来 换成 如下 才解决,

使用python写文件的时候,或者将网络数据流写入到本地文件的时候,大部分情况下会遇到:UnicodeEncodeError: ‘gbk’ codec can’t encode character ‘\xa0’ in position … 这个问题。 网络上有很多类似的文件讲述如何解决这个问题,但是无非就是encode,decode相关的,这是导致该问题出现的真正原因吗?不是的。 很多时候,我们使用了decode和encode,试遍了各种编码,utf8,utf-8,gbk,gb2312等等,该有的编码都试遍了,可是编译的时 候仍然出现: UnicodeEncodeError: ‘gbk’ codec can’t encode character ‘\xa0’ in position XXX。 崩溃了。

将网络数据流写入文件时时,我们会遇到几个编码:

1: #encoding=’XXX’ 这里(也就是python文件第一行的内容)的编码是指该python脚本文件本身的编码,无关紧要。只要XXX和文件本身的编码相同就行了。 比如notepad++ “格式”菜单里面里可以设置各种编码,这时需要保证该菜单里设置的编码和encoding XXX相同就行了,不同的话会报错

2:网络数据流的编码 比如获取网页,那么网络数据流的编码就是网页的编码。需要使用decode解码成unicode编码。

3:目标文件的编码 要将网络数据流的编码写入到新文件,那么我么需要指定新文件的编码。写文件代码如:

f.write(txt)

,那么txt是一个字符串,它是通过decode解码过的字符串。关键点就要来了:目标文件的编码是导致标题所指问题的罪魁祸首。如果我们打开一个文件:

f = open("out.html","w"),在windows下面,新文件的默认编码是gbk,这样的话,python解释器会用gbk编码去解析我们的网络数据流txt,然而txt此时已经是decode过的unicode编码,这样的话就会导致解析不了,出现上述问题。 解决的办法就是,改变目标文件的编码:

f = open("out.html","w",encoding='utf-8')

总结:

python 编码真的是一个头疼的问题。

0